# 앙상블

- Soft voting: 각 Softmax확률의 평균을 낸다음 argmax

- Hard voting: 각 softmax에서 argmax한 다음 아래와 같은 방법으로 voting

* Unanimous voting: 만장일치일 때만 decision함

* Majority voting: 다수결로 선택된 decision이 전체의 50%를 넘어야됨.

* Plurality voting: 각각의 softmax에대해 argmax한다음 가장 다수의 의견을 따름.(50%를 넘지 않아도 됨)

- Weighted voting: Soft 혹은 Hard voting에서 각 softmax에 임의의 weight를 주어서 사용.(확률에 대해선 weighted sum, Hard에 대해서는 2표를 행사할 수 있음)

- Staking: 각각의 모델이 내놓은 decision을 추가적인 feature로 사용하는, 또다른 classifier를 training set에 대해 학습시킴.

- 내가 제안하는 방법: Confident opinion + majority voting

softmax들 중, confidence가 높은 의견들을 모아서 majority voting을 수행. 만약 confidence가 여러가지 기준을 갖고 있다면, 각 criterion 별로 중복해서 softmax를 뽑고, 이 의견들을 모아서 다수의견이 일정 threshold 이상 차지해야 의견 채택. 아니면 모름

- 참고문헌

2. https://en.wikipedia.org/wiki/Ensemble_learning

3. http://scikit-learn.org/stable/modules/ensemble.html

'Research > Deep Learning & Application' 카테고리의 다른 글

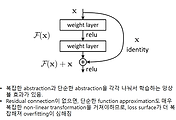

| Residual connection (0) | 2019.10.22 |

|---|---|

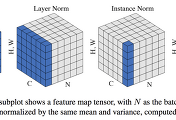

| 각종 Normalization technique (2) | 2019.10.22 |

| Computer Vision Techniques (0) | 2017.03.15 |

| Word2Vec, Bag-Of-Words, 최신 word embedding (2) | 2015.08.03 |

| RNN의 Vanishing Gradient와 Exploding Gradient (0) | 2015.07.08 |

댓글